摘要

本文主要研究了不同联邦学习环境下的矩阵分解(MF)问题,提出了一个通用的联邦矩阵分解(FMF)算法框架,系统地表征了垂直联邦学习(VFL)、水平联邦学习(HFL)和本地联邦学习(LFL)三种不同设置的数据采集、训练和发布阶段的隐私泄露风险,并引入隐私概念和一种新的被称为嵌入裁剪的私有学习技术以提供端到端的隐私保护。

介绍

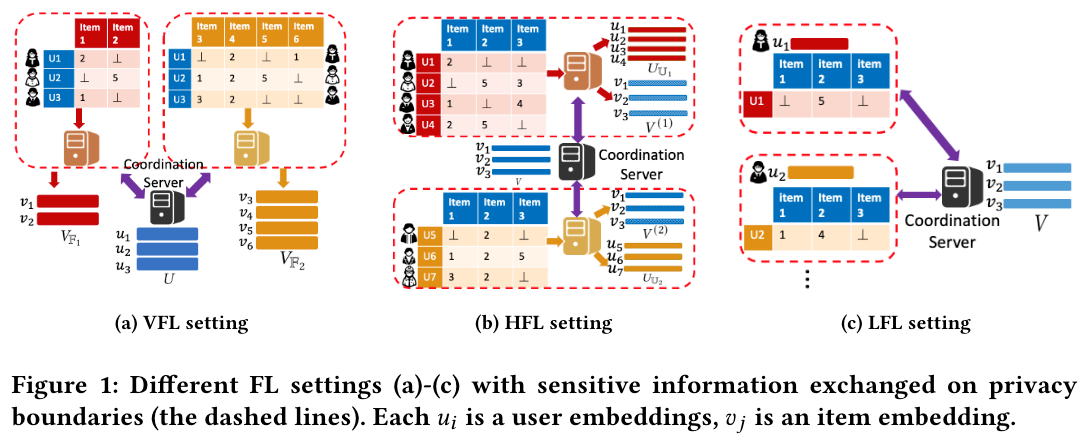

本章主要介绍了一些联邦学习的概念和三种不同设置的联邦学习(VHL、HFL、LFL)所需要的不同的隐私边界设置。

本文的贡献如下:

- 提出了一个应用于三种设置的抽象的计算范式

- 针对不同的隐私泄露风险为不同的设置设计了不同的 FL 算法

- 提出使用嵌入裁剪(Embeddings Clipping)代替梯度裁剪(Gradient Clipping)来进行更新

- 提出了用于矩阵分解的 SGDMF 算法(包括 VFL-SGDMF、HFL-SGDMF、LFL-SGDMF)

背景

本章主要介绍了一些背景知识,如矩阵分解、差分隐私等

矩阵分解

矩阵分解问题可以形式化为如下最小化损失函数:

差分隐私

-

Sequential composition: moments accountant

在

其中上界为

Moments Accountant 将总体隐私损失限制在 -

Moments Accountant

设机制

(1) 对任何

(2) 对任何 -

Parallel Composition

若 -

Per-rating Privacy

当有一索引

Per-rating Privacy 保护每个单独的由每个用户给出的评分 -

Bounding Sensitivity

Sensitivity 指的是当数据有一条发生变化(增加 / 删除)时所产生的影响 -

Gradient Clipping

梯度裁剪可以用于 Bounding Sensitivity,但是在实际应用中有限制每个评分的效果和需要额外空间存储每个评分梯度的问题 -

Trimming

限制参与方

联邦矩阵分解

本章介绍了在三种不同设置(VFL、HFL、LFL)下的矩阵分解

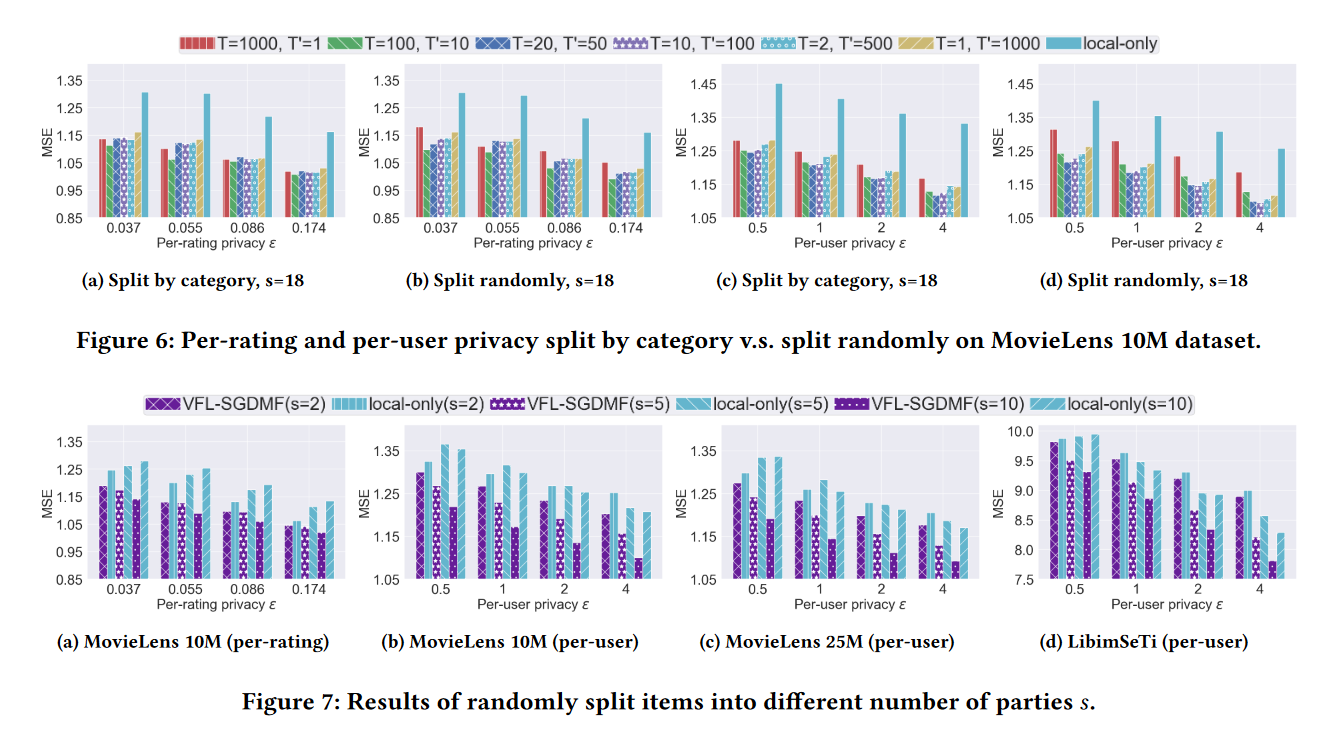

垂直联邦学习(VFL)下的矩阵分解

User embeddings

Item embeddings

对参与方

整体损失函数:

User Embeddings:

Item Embeddings:

User Embaddings 的归一化随机梯度:

Item Embaddings 的归一化随机梯度:

水平联邦学习(HFL)下的矩阵分解

局部损失函数:

全局损失函数:

本地联邦学习(LFL)下的矩阵分解

LFL 是一种当

MF 问题常用的 FL 范式

- 初始化和局部预计算

- 联合学习(需要通信)

- 局部微调

在 VFL 中,share embedding 是 user embedding,而在 HFL 中,share embedding 是 item embedding

在上述三个步骤中,步骤 1、3 可以在本地完成,而步骤 2 需要通信,更新步骤如下:

VFL:

HFL:

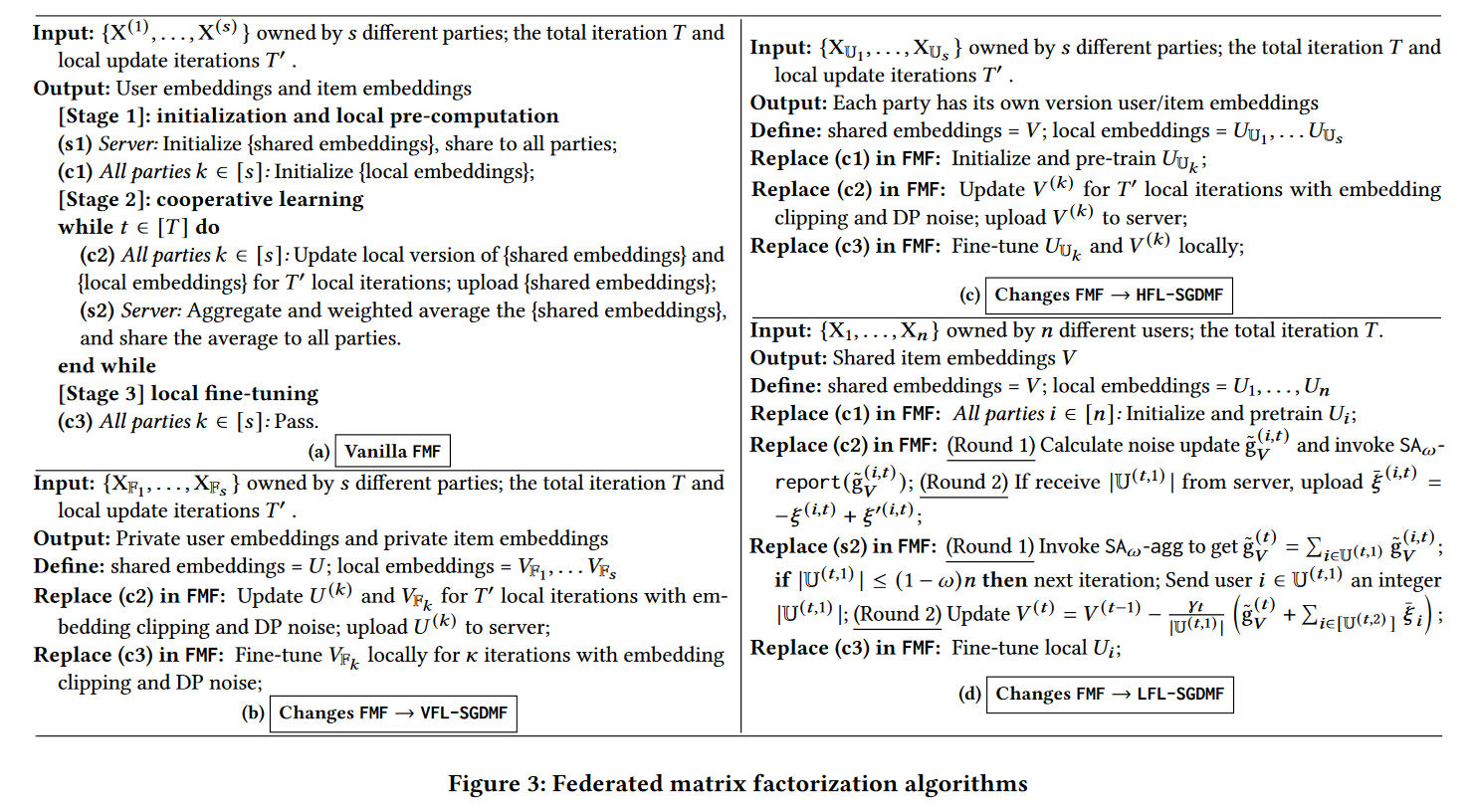

算法描述如下 Figure 3:

隐私垂直联邦学习矩阵分解 VFL-SGDMF

Embedding Clipping

因为所有评分都在

Random Trimming

对每个参与方

隐私放大

通过使用 mini-batch 技术可实现隐私放大,对数据进行采样

隐私局部更新

为了保护中间和最终结果,

局部更新 U:

局部更新 V:

其中

VFL-SGDMF 局部微调

VFL-SGDMF 算法的收敛取决于两方面:DP 噪声和问题的非凸性

对最后的

隐私水平联邦学习矩阵分解 HFL-SGDMF

- 初始化和局部预计算

- 联合学习

每个参与方使用差分隐私保护更新本地 item embeddings: - 局部微调

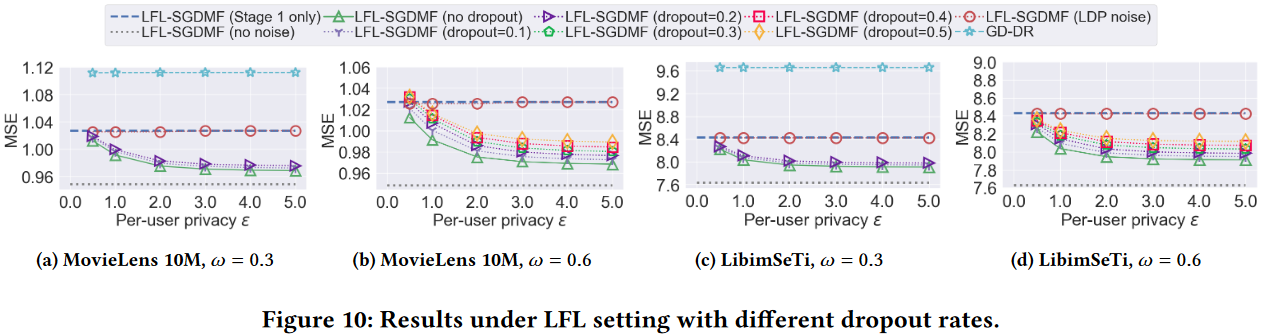

跨设备学习:LFL-SGDMF

不同于 HFL,LFL 可能会面临用户设备不可用或用户设备与中心方之间的通信断开的情况,所以需要保证在训练过程中即使有大量用户在一次或多次迭代中退出的情况下 LFL 仍然可以可以保证隐私性。

LFL-SGDMF 改编自 FMF 算法,主要对第二步联合学习进行了修改,基本思想是在通过 SA(Secure Aggregation)聚合 item embeddings 的更新的同时保证聚合梯度满足 DP,同时引入尽可能小的噪声。

如果将 SA 看作一个预言机,则在每轮迭代中都会有两轮通信。

-

第一轮通信

协调服务器发起 -

第二轮通信

协调服务器首先向幸存者广播

LFL-SGDMF 对每个参与方的通信成本为